El III-LIDI participó de la EXPO CIENCIA 2024 a través de la presentación de 4 proyectos de desarrollo e innovación con alumnos coordinados por el Instituto.

INTEGRACIÓN DE ROBOTS Y NODOS SENSORES A SERVICIOS Y PLATAFORMAS

DIRECTORES: Santiago Medina y Diego Montezanti

AUTORES: Manuel Silenzi, Daniel Dell’arciprete y Octavio Pérez Balcedo

Este proyecto fue desarrollado dentro de la línea de investigación que estudia el despliegue e integración de arquitecturas distribuidas para el almacenamiento, gestión y visualización de datos generados por nodos sensores que están desplegados en algún ambiente físico.

La arquitectura distribuida estudiada consta de 4 niveles, partiendo desde la capa inferior, que consiste en los nodos sensores que recolectan información del ambiente, pasando por las capas intermedias de Edge y Fog Computing, que ofrecen recursos a los nodos finales con mayor cercanía, y por ultimo la capa de Cloud Computing, que ofrece todo tipo de servicios desde internet.

El desarrollo del proyecto se dividió en dos subproyectos:

- Despliegue e integración de una red de sensores de CO2 con la plataforma IoT Home Assistant

- Despliegue de un nodo Edge para el control de un robot navegador con diferentes tipos de mandos.

JUEGOS SERIOS CON OBJETOS INTERACTIVOS

DIRECTORES: Cecilia Sanz y Verónica Artola

TUTORES: Mauricio Nordio y Joaquín Tartaruga

AUTORES: Justina Terruzzi, Juan Furci, Sabrina Lombardo y Matías Zeballos

El proyecto se enmarca en una línea de investigación, desarrollo e innovación que se viene abordando en el III-LIDI y se enfoca en la interacción persona-ordenador aplicada al ámbito educativo, además del diseño de juegos serios. Este año se trabajaron dos iniciativas principales. La primera es un juego serio relacionado con la salud y las emociones, utilizando una mesa interactiva en una sala de escape educativa con temática de Star Wars. El juego tiene dos etapas y está dirigido a jóvenes de 13 a 20 años. El desarrollo implicó la creación de una interfaz flexible con integración de multimedia, y los estudiantes trabajaron en un backend en Java y un frontend web.

El segundo proyecto, llamado «Reflector Mágico», se centra en el uso de sensores, interacción tangible y mapeo de proyecciones, ofreciendo nuevas formas de explorar narrativas digitales. En ambos proyectos participaron estudiantes y docentes de diferentes disciplinas, y aunque están en desarrollo, han permitido investigar estrategias de interacción tangible.

APLICACIONES MÓVILES 3D, REALIDAD VIRTUAL Y REALIDAD AUMENTADA

DIRECTORES: Sebastián Dapoto y. Federico Cristina.

AUTORES: Lautaro Barbero, Tiago Restucha e Ignacio A. Schwindt

Las aplicaciones móviles 3D con realidad virtual (RV) permiten a los usuarios explorar conceptos complejos en un entorno visual y práctico. Por otro lado, la realidad aumentada (RA) permite a los usuarios interactuar con elementos virtuales superpuestos al mundo real, enriqueciendo la experiencia de uso.

Ubicarse y desplazarse en entornos desconocidos puede ser un reto importante. Facilitar que los estudiantes se familiaricen con el edificio de la facultad antes de visitarlo en persona resulta especialmente útil, ya que les permite conocer su futuro entorno de estudio y adaptarse mejor a su nuevo contexto.

El objetivo principal del proyecto fue el de actualizar un modelo existente incompleto de la Facultad de Informática y luego crear una aplicación en la que se pudiera explorar el edificio mediante el uso de gafas RV.

La aplicación fue desarrollada en Unity haciendo uso del Google Cardboard SDK.

Inicialmente de completó el modelo 3D de la facultad, agregando las aulas y espacios faltantes. Se incorporó el modelo terminado al entorno de Unity, en donde se agregó un sistema de desplazamiento y colisiones para que el usuario pueda desplazarse con el movimiento de su cabeza. Por último, para mejorar la experiencia, se integraron una serie de carteles a cada aula, informando la materia en curso, su docente y horarios.

TINYML: INTEGRANDO APRENDIZAJE AUTOMÁTICO EN SISTEMAS EMBEBIDOS

DIRECTORES: César Estrebou y Marcos David Saavedra

AUTORES: Santiago Chaves, Marina G. Cuello, Eduardo Kusznieryk y Nicolás Ricciardi.

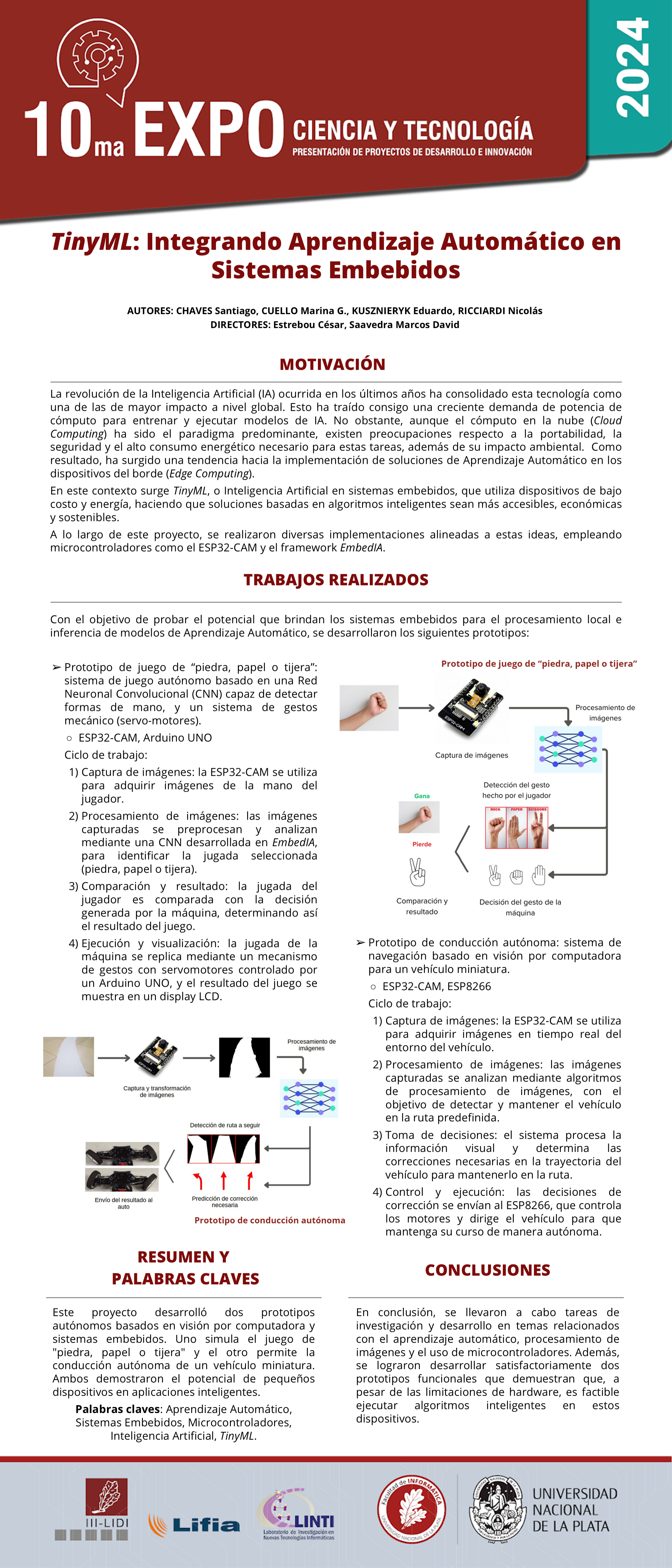

La revolución de la Inteligencia Artificial (IA) ocurrida en los últimos años ha consolidado esta tecnología como una de las de mayor impacto a nivel global. Esto ha traído consigo una creciente demanda de potencia de cómputo para entrenar y ejecutar modelos de IA. No obstante, aunque el cómputo en la nube (Cloud Computing) ha sido el paradigma predominante, existen preocupaciones respecto a la portabilidad, la seguridad y el alto consumo energético necesario para estas tareas, además de su impacto ambiental. Como resultado, ha surgido una tendencia hacia la implementación de soluciones de Aprendizaje Automático en los dispositivos del borde (Edge Computing).

En este contexto surge TinyML, o Inteligencia Artificial en sistemas embebidos, que utiliza dispositivos de bajo costo y energía, haciendo que soluciones basadas en algoritmos inteligentes sean más accesibles, económicas y sostenibles.

A lo largo de este proyecto, se realizaron diversas implementaciones alineadas a estas ideas, empleando microcontroladores como el ESP32-CAM y el framework EmbedIA.

Con el fin de demostrar el potencial de pequeños dispositivos en aplicaciones inteligentes se desarrollaron dos prototipos autónomos basados en visión por computadora y sistemas embebidos. Uno simula el juego de «piedra, papel o tijera» y el otro permite la conducción autónoma de un vehículo miniatura.